Vortrag im Rahmen von Regionalveranstaltungen der tekom Deutschland, im Januar und März 2025.

Knowledge Management & AI Consulting

Beratung für Unternehmen und Institutionen

Vortrag im Rahmen von Regionalveranstaltungen der tekom Deutschland, im Januar und März 2025.

Diese Präsentation von der Semantics 2023 erläutert die Kernpunkte des Europäischen Green Deals, zugehörige Sustainable Produktinitiativen und Standards und – als Use Case – Konzepte zur Realisierung des Digitalen Produktpasses (Digital Product Passport – DPP) auf der Basis neuester Technologien und Frameworks, z.B. der Anwendung der Asset Administration Shell (AAS) in Verbindung mit einem Enterprise Knowledge Graph (EKG).

Download der Präsentation (pdf, 2,5 MB)

In der heutigen digitalen Welt nehmen Large Language Models (LLMs) und verwandte Technologien eine zentrale Rolle in der Verarbeitung und Analyse natürlicher Sprache ein. Diese Modelle haben das Potenzial, die Art und Weise, wie Unternehmen Informationen verarbeiten und nutzen, grundlegend zu verändern. In diesem Beitrag erläutern wir die Konzepte von LLM, Retrieval-Augmented Generation (RAG) und GraphRAG und wie sie in der Industrie angewendet werden können.

LLMs sind leistungsstarke KI-Modelle, die darauf trainiert sind, menschliche Sprache zu verstehen und zu generieren. Sie basieren auf tiefen neuronalen Netzen und werden mit riesigen Mengen an Textdaten trainiert. Dies ermöglicht ihnen, komplexe Muster und Zusammenhänge in der Sprache zu erkennen. LLMs finden Anwendung in zahlreichen Bereichen, von Chatbots und virtuellen Assistenten bis hin zur automatisierten Textanalyse und -generierung.

Retrieval-Augmented Generation (RAG) kombiniert die Fähigkeiten von LLMs mit Informationsabrufsystemen. Anstatt sich ausschließlich auf das trainierte Modell zu verlassen, greift RAG auf externe Datenquellen zu, um bei der Generierung von Antworten präzisere und kontextrelevantere Informationen bereitzustellen. Diese Methode verbessert die Genauigkeit und Relevanz der generierten Inhalte erheblich, indem sie aktuelle und spezialisierte Informationen in den Prozess einbezieht.

GraphRAG ist eine Erweiterung des RAG-Prinzips, die die Struktur von Wissensgraphen nutzt, um die Informationsabruf- und Generierungsprozesse weiter zu optimieren. Wissensgraphen stellen Daten in einer netzwerkartigen Struktur dar, die Beziehungen zwischen verschiedenen Informationen verdeutlicht. Durch die Integration von Wissensgraphen kann GraphRAG tiefere Einblicke und fundierte Antworten liefern, indem es nicht nur relevante Daten abruft, sondern auch deren Zusammenhänge berücksichtigt.

Dieser AI-Technologien bieten vielfältige Einsatzmöglichkeiten in der Industrie. LLMs können zur Automatisierung von Kundeninteraktionen oder zur Unterstützung von Entscheidungsprozessen eingesetzt werden. RAG und GraphRAG ermöglichen es Unternehmen, ihre Datenressourcen effizienter zu nutzen und fundierte, datengetriebene Entscheidungen zu treffen. Besonders in datenintensiven Branchen wie dem Gesundheitswesen, der Finanzwirtschaft oder der Logistik können diese Technologien erhebliche Wettbewerbsvorteile bieten.

Zusammenfassend lässt sich sagen, dass LLMs, RAG und GraphRAG bedeutende Werkzeuge für die Transformation von Geschäftsprozessen darstellen. Durch die Integration dieser Technologien können Unternehmen ihre Effizienz steigern, ihre Innovationskraft erhöhen und sich besser auf die Anforderungen des Marktes einstellen.

Standards ermöglichen und sichern die erfolgreiche, sichere und zukunftsweisende Einführung neuer und komplexer Technologien in Unternehmen. Der Standard ISO/IEC 42001:2023 ist ein Leitfaden für die Einführung und den Betrieb von AI-Anwendungen aus der (System-) Management Perspektive. Er beschreibt die Anforderungen an AI-Lösungen und beschreibt die Aspekte einer erfolgreichen Einführung, eines Betriebs und eines ständigen Verbesserungsprozesses für Lösungen im Bereich der Künstlichen Intelligenz.

Die Digitale Transformation bezeichnet einen umfassenden, in der Anwendung neuer digitaler Technologien und agilen Herangehensweisen begründeten Umwandlungsprozess, der alle Bereiche und Prozesse eines Unternehmens oder auch einer Institution betrifft.

Im Zusammenhang mit der Anwendung und Integration digitaler Technologien spricht man auch von „Cognitive Computing“, welches auf Lösungen aus den Bereichen Knowledge Discovery, Text Mining, Natural Language Processing und Machine Learning basiert.

Die Fähigkeit der Adaption an sich ändernde Bedingungen und Informationen sowie die systematische Lernfähigkeit aller Komponenten sind, neben der Berücksichtigung des Kontexts der Anwendung, die wichtigsten Fähigkeiten des Cognitive Computing.

Die Digitale Transformation (ebenso wie jede Knowledge Management Transformation) muss alle Domains in einem Unternehmen oder in einer Institution berücksichtigen, eine Transformation der Technologien allein ist nicht genügend (z.B. die Organisation, Mitarbeiter, Prozesse, Strategie – siehe dazu „Kernelemente der Digitalen Transformation„).

In den letzten Jahren wurden unterschiedliche Definitionen und Herangehensweisen entwickelt, die sich mit Daten-, Informations- und Wissens-Management beschäftigen.

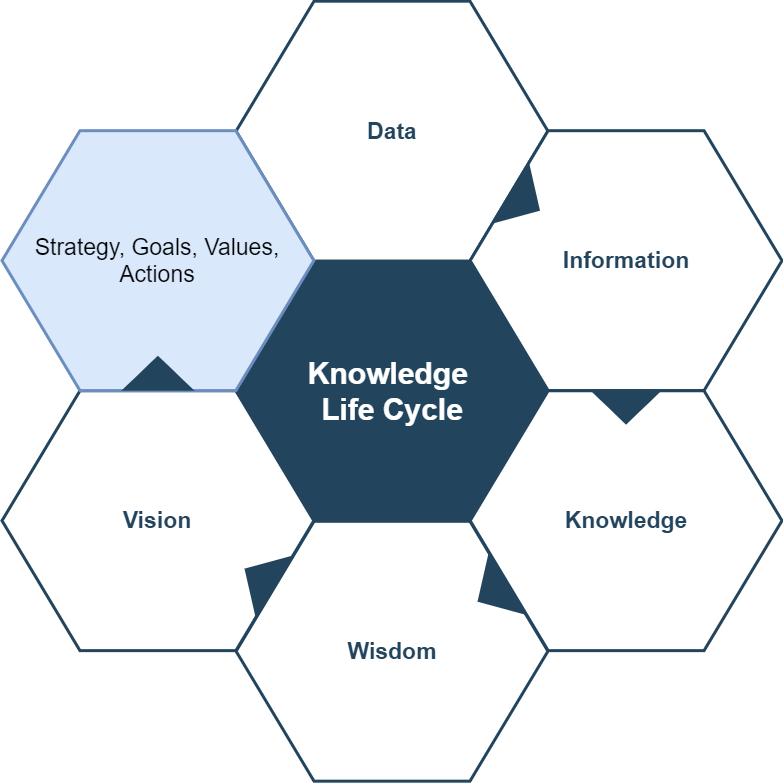

Es bietet sich an, dies im Gesamtkontext eines Unternehmens oder einer Institution zu betrachten. Das folgende Diagramm zeigt den gesamten, sich wiederholenden Zyklus unter Berücksichtigung von Zwischenphasen.

Zur Erläuterung schauen wir uns die Phasen näher an und starten dabei mit der Phase „Data“.

Während des Prozesses des Daten-Managements werden anfänglich Discrete Data in Connected Data transformiert. Connected Data lassen sich durch einen Knowledge Graph oder einen Knowledge Forest beschreiben und verwalten.

Das Semantic Web stellt eine Entwicklungsstufe des WWW dar. Es erweitert das Web, um veröffentlichte Informationen und Daten auch zwischen Maschinen lesbar, austauschbar und verwertbar machen zu können. Die Informationen werden mit eindeutigen Bedeutungen versehen und durch zusätzliche Details ergänzt, so dass Mensch und Maschine die Bedeutung, den Kontext und weitere Zusammenhänge der Information (die Semantic) erkennen können.

Das Semantic Web basiert auf einer Wissensmodellierung bzw. Wissensrepräsentation (für eine Wissens-Domain).

Tim Berners-Lee (Begründer des World Wide Web) beschrieb seinen Vorschlag im Jahr 2001 folgendermaßen: „The Semantic Web is an extension of the current web in which information is given well-defined meaning, better enabling computers and people to work in cooperation“).

Dies ist eine kleine Auswahl empfohlener Buchtitel im Kontext von Knowledge Management, Semantic Web, Knowledge Graph, Taxonomy & Ontologie und Artificial Intelligence.

The KM Cookbook

Chris J. Collison et al., facet publishing, 2019.

Stories and strategies for organisations exploring Knowledge Management Standard ISO 30401

Knowledge Management Matters

John & JoAnn Girard, Sagology, 2018.

Words of Wisdom from Leading Practitioners

The Knowledge Graph Cookbook

Andreas Blumauer, Helmut Nagy, 2020.

The Knowledge Graph Cookbook explains why your organisation should invest in the development of knowledge graphs, and most importantly, what recipes exist for developing and integrating them in an efficient, successful and sustainable way.

Graph Powered Machine Learning

Alessandro Negro, Manning Publications, 2020*.

Graph-Powered Machine Learning introduces you to graph technology concepts, highlighting the role of graphs in machine learning and big data platforms. You’ll get an in-depth look at techniques including data source modeling, algorithm design, link analysis, classification, and clustering. As you master the core concepts, you’ll explore three end-to-end projects that illustrate architectures, best design practices, optimization approaches, and common pitfalls.

* Buch erscheint im Dezember 2020 – eine gekürzte Vorabversion „Essential Excerpts“ wurde im Juli 2020 veröffentlicht.

Ontology Engineering

Elisa F. Kendall et al., Morgan & Claypool Publishers, 2019.

Synthesis Lectures on the Semantic Web: Theory and Technology. Ontologies have become increasingly important as the use of knowledge graphs, machine learning, natural language processing (NLP), and the amount of data generated on a daily basis has exploded.

An Introduction to Ontology Engineering

C. Maria Keet et al., CC BY 4.0, 2020.

The principal aim of this textbook is to provide the student with a comprehensive

introductory overview of ontology engineering. A secondary aim is to provide

hands-on experience in ontology development that illustrate the theory, such as

language features, automated reasoning, and top-down and bottom-up ontology

development with methods and methodologies.

Semantic Web for the Working Ontologist: Effective Modeling for Linked Data, Rdfs, and Owl

Dean Allemang et al., ACM Books, 2020.

Enterprises have made amazing advances by taking advantage of data about their business to provide predictions and understanding of their customers, markets, and products. But as the world of business becomes more interconnected and global, enterprise data is no long a monolith; it is just a part of a vast web of data. Managing data on a world-wide scale is a key capability for any business today.

Semantic Modeling for Data: Avoiding Pitfalls and Breaking Dilemmas

Panos Alexopoulos, O’Reilly, 2020

What value does semantic data modeling offer? As an information architect or data science professional, let&;s say you have an abundance of the right data and the technology to extract business gold&;but you still fail. The reason? Bad data semantics. In this practical and comprehensive field guide, author Panos Alexopoulos takes you on an eye-opening journey through semantic data modeling as applied in the real world. You’ll learn how to master this craft to increase the usability and value of your data and applications. You’ll also explore the pitfalls to avoid and dilemmas to overcome for building high-quality and valuable semantic representations of data.